Snowflake s'appuie sur les LLM de Mistral AI pour améliorer l'analyse en libre-service.

Au-delà des requêtes de base, une précision 2x plus élevée avec le text-to-SQL de Snowflake

Snowflake est un fournisseur Cloud de données IA, qui permet aux entreprises de tirer plus de valeur de leurs données, en traitant des milliards de requêtes chaque jour pour des milliers de clients, afin d’obtenir d’importantes informations commerciales. La clé du succès de [Cortex Analyst] (https://docs.snowflake.com/fr/user-guide/snowflake-cortex/overview), leur assistant alimenté par l’IA pour les données structurées, réside dans un partenariat avec Mistral AI et l’intégration de deux LLM, Mistral Large et Codestral, sélectionnés pour leur excellente compréhension du langage naturel et leur capacité à générer du SQL.

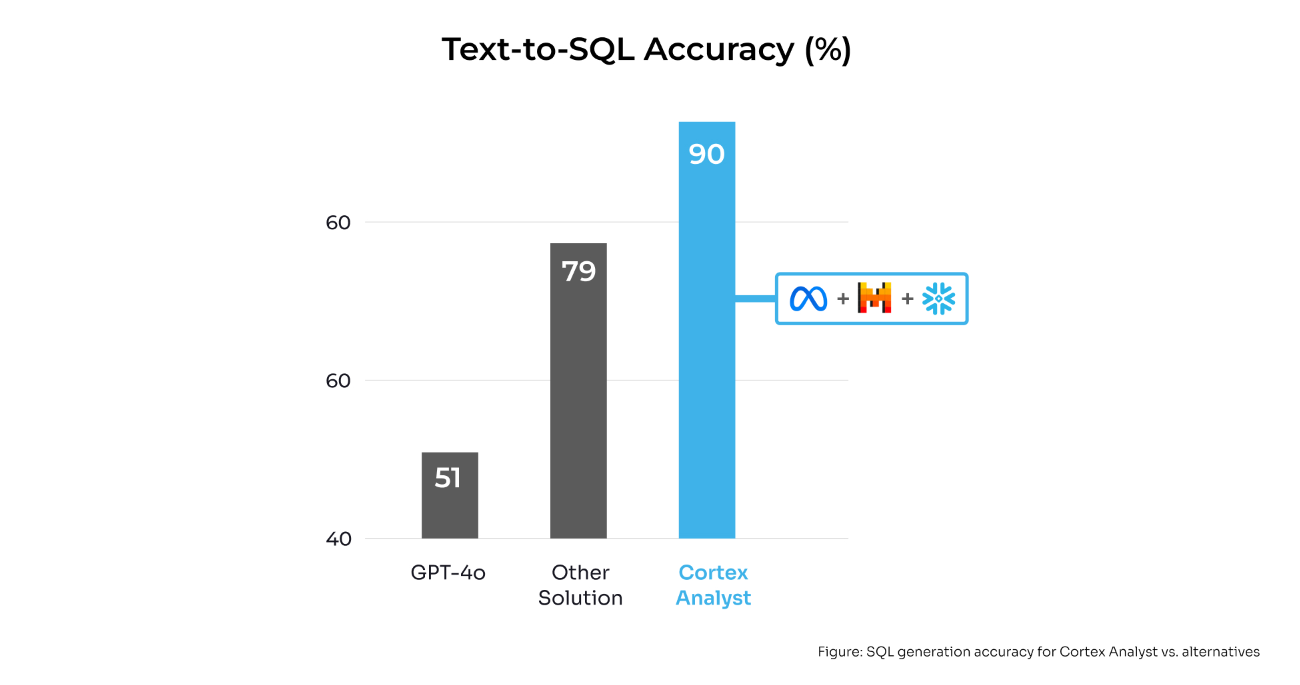

En tirant parti des LLM de Mistral AI, Snowflake Cortex Analyst a atteint :

Une précision2Xsupérieure à celle des LLM de pointe.

14 % de précision en plus sur les solutions concurrentes

Une précision de 90 % minimum à chaque évaluation client

Cette collaboration a redéfini les normes de l’expérience utilisateur dans les produits SQL d’IA générative. Il est ainsi plus facile pour les équipes non techniques d’accéder rapidement à l’analyse en libre-service.

Contexte

La demande de LLM pour l’interprétation des données s’accroît à mesure que les clients cherchent à accéder à des informations issues de données structurées et non structurées. L’équipe de développement de Snowflake avait besoin d’une solution pour Cortex Analyst, capable d’une part de générer du SQL avec expertise, et d’autre part, d’offrir des compétences conversationnelles pour des interactions en langage naturel de haute qualité. La précision étant essentielle pour les équipes Data et les utilisateurs professionnels qui utilisent les résultats des requêtes pour prendre des décisions opérationnelles critiques, la solution devait être à la pointe de la technologie et surpasser les métriques d’évaluation existantes.

SQL : Un frein à la compréhension rapide

Toute personne amenée à écrire fréquemment des requêtes SQL dans un cadre professionnel doit apprendre à trouver le bon schéma et à comprendre les nuances des ensembles de données complexes, ce qui n’est pas toujours facile. En outre, les requêtes SQL peuvent être subtiles et ambiguës, et la “bonne” réponse peut être écrite de plusieurs façons. La rédaction et l’optimisation des requêtes SQL peuvent être complexes et chronophages pour les utilisateurs non techniques. Il est donc essentiel que l’expérience utilisateur soit transparente et intuitive pour favoriser l’adoption et la satisfaction d’une base d’utilisateurs diversifiée.

Pour assurer un accès plus rapide aux informations, Snowflake souhaitait améliorer Cortex Analyst avec des capacités text-to-SQL très précises. L’objectif était de développer des fonctionnalités text-to-SQL extrêmement précises, capables de gérer des ensembles de données complexes, en simplifiant l’apprentissage relatif à l’identification des schémas et en offrant une expérience intuitive aux utilisateurs non techniques. Plus important encore, Snowflake devait garantir une précision absolue pour soutenir les décisions opérationnelles critiques.

Codestral et Mistral Large : Des réponses précises et conversationnelles

Snowflake devait générer une requête SQL, évaluer cette requête pour en vérifier l’exactitude et corriger tout problème potentiel, puis transmettre la requête et les informations pertinentes de manière conversationnelle aux utilisateurs professionnels. Snowflake s’est tourné vers deux modèles Mistral comme solutions potentielles : Codestral, un modèle à poids ouvert expressément conçu pour les tâches de génération de code, et Mistral Large, pour le raisonnement, la génération de langage et la génération de code.

Pour la génération de requêtes robustes, Snowflake utilise une approche en deux étapes : elle demande d’abord à plusieurs agents de générer du code SQL, puis à un autre agent de synthétiser le code SQL final en se basant sur les réponses des experts. Snowflake utilise Mistral Large et un Codestral fine-tuné pour la génération initiale de SQL, puis Codestral pour synthétiser la réponse SQL finale.

Cortex Analyst devait également présenter les requêtes et les informations contextuelles importantes de manière conversationnelle, en utilisant un langage naturel que tout utilisateur, quelle que soit son expertise technique, puisse comprendre. Il fallait également identifier les questions ambiguës ou sans réponse au regard des données disponibles, puis en avertir l’utilisateur ou lui proposer des solutions alternatives.

Mistral Large a joué un rôle essentiel en offrant à la fois ses connaissances en SQL et sa qualité de conversation. Les explications supplémentaires sur la manière dont la requête a été générée et la documentation de référence donnent confiance aux utilisateurs dans le résultat et leur permettent de faire des recherches plus approfondies si nécessaire.

Pourquoi Mistral AI ?

Snowflake a choisi les modèles Mistral Large et Codestral pour :

Leurs capacités supérieures de compréhension du langage naturel et de génération de SQL

Leur solide performance dans les tâches de génération de code et de raisonnement

Leur capacité à fournir des explications conversationnelles de haute qualité

Leur avantage concurrentiel en expertise SQL par rapport aux autres modèles

Résultats et impact : Établir de nouvelles normes en matière de précision et d’expérience utilisateur

Les résultats étaient impressionnants. Sur la base d’ensembles d’évaluations internes utilisant Mistral Large et Codestral, Cortex Analyst atteint systématiquement une précision 2x supérieure à celle de la génération SQL en un seul essai des LLM de pointe et offre une précision supérieure de 14 % à celle d’une autre solution de text-to-SQL concurrente sur le marché. De plus, Cortex Analyst atteint 90 % de précision minimum lors des évaluations clients et des tests de référence, ce qui est essentiel pour les cas d’utilisation en entreprise.

Au-delà des améliorations numériques, la collaboration entre Snowflake et Mistral AI a établi une nouvelle norme pour l’expérience utilisateur dans les produits SQL d’IA générative. Elle a amélioré les interactions en langage naturel pour les utilisateurs non techniques, ainsi que la capacité à identifier les questions ambiguës et à suggérer des alternatives. Ce partenariat a permis à Snowflake de tenir davantage sa promesse de démocratiser l’IA générative pour les clients et d’apporter de la valeur à leurs données d’entreprise.

Cap sur l’avenir : Etendre la portée de l’analyse des données

À mesure que Snowflake accroît l’accessibilité des informations sur les données grâce à des applications de données alimentées par l’IA, la collaboration avec Mistral AI ouvre de nouvelles perspectives. Une meilleure qualité des sorties engendre la satisfaction et l’adoption des utilisateurs, ce qui permet aux équipes chargées des données de créer en toute confiance des applications métier à l’aide de solutions de pointe, sans les problèmes de précision, de latence et de coûts liés à l’élaboration et à la maintenance de modèles internes.

Le partenariat entre Snowflake et Mistral AI ne constitue que les prémices de notre démarche visant à fournir aux clients un accès rapide et avisé aux données, en rendant l’analyse en libre-service plus accessible et plus efficace pour les entreprises de divers secteurs.

Pour en savoir plus sur les raisons qui poussent les entreprises du monde entier à faire confiance à Mistral AI pour des LLM ouverts, efficaces et performants, consultez nos témoignages clients sur https://mistral.ai/fr/customers.